Alter im Code – wie digitale Systeme Lebensphasen modellieren

Plattformen erfassen Alter nicht mehr nur, sie modellieren es. Aus Verhalten werden Wahrscheinlichkeiten. Aus Wahrscheinlichkeiten werden Entscheidungen. Welche Rolle soll Alter im Code künftig spielen? Wer definiert, was als normal gilt?

Alter als Ordnungsprinzip moderner Gesellschaften.

Discord hat ankündigt, das Alter seiner Nutzer:innen nicht mehr allein über Selbstauskunft zu erfassen, sondern über Verhaltensmuster zu inferieren. Ein System, das aus Nutzungsdaten, Interaktionsmustern und systemseitigen Parametern eine Alterswahrscheinlichkeit ableitet. Es geht um Jugendschutz. Das Anliegen ist richtig. Der digitale Raum braucht dringend verläßliche Schutzmechanismen.

Trotzdem: Diese Entscheidung steht für eine größere Verschiebung.

Alter war lange eine Konstante. Ein Datum. Eine Zahl. Ein administrativer Fakt. Man wird geboren, man wird gezählt, man wird eingeordnet. Schulreife. Wahlrecht. Rente. Lebensphasen als klare Sequenz. Das Geburtsjahr strukturiert Biografien, Institutionen und Märkte. Es ist grob, aber stabil. Und diese Stabilität war nie neutral. Sie entschied, wer früh Verantwortung bekam. Und wer warten musste.

Im Digitalen löst sich diese Stabilität zunehmend auf.

Alter wandert aus Formularfeldern in Modelle.

Aus der Selbstauskunft in statistische Ableitung.

Digitale Systeme transformieren Alter von einer Angabe zu einer Zuschreibung.

Nicht nur Discord analysiert Interaktionsmuster, Account-Historien und technische Parameter, um das Alter seiner Nutzer:innen zu inferieren, um daraus eine Alterswahrscheinlichkeit zu modellieren.

Auch Open Ai hat angekündigt im Kontext von ChatGPT Alter zu inferieren. Und Spotify zeigte zum Jahreswechsel die weichere Variante, indem aus Hörgewohnheiten ein individuelles Alter wurde. Modelliert nach musikalischen Vorlieben.

Mit der Berechnung von Alter verschiebt sich die Definitionsmacht.

Dass diese Entwicklung nicht trivial ist, zeigt auch die Forschung. Die Gefahr, dass Altersbilder in Trainingsdaten und Modellen verfestigt werden ist belegbar. In der KI-Ethik spricht man inzwischen von „algorithmic ageism“.

Studien weisen darauf hin, dass KI-Systeme Alterszuschreibungen reproduzieren können, selbst wenn diese nie explizit programmiert wurden. Bias entsteht durch Datenlage und Modellarchitektur.

Modelle lernen aus historischen Nutzungsdaten, Textkorpora, Interaktionsmustern, Plattformlogiken. Wenn bestimmte Altersgruppen in diesen Daten häufiger mit bestimmten Themen, Stilen oder Rollen auftauchen, werden diese Muster statistisch stabil. Das Modell lernt Korrelationen, keine Intentionen. Es erkennt Wiederholungen und verstärkt sie.

Damit verschiebt sich dann auch der Fokus. Die Frage lautet nicht mehr nur, wie ein Modell programmiert wurde, sondern welche Realität ihm zum Lernen gegeben wurde. Wer ist im Datensatz sichtbar? Wer fehlt? Welche Altersbilder sind implizit bereits codiert?

Altersmodelle beruhen auf Annahmen darüber, was „typisch“ ist.

Welche Sprachmuster gelten als Indikator für Minderjährigkeit?

Welche Interaktionsdichte als Zeichen von Reife?

Welche Themen als altersangemessen?

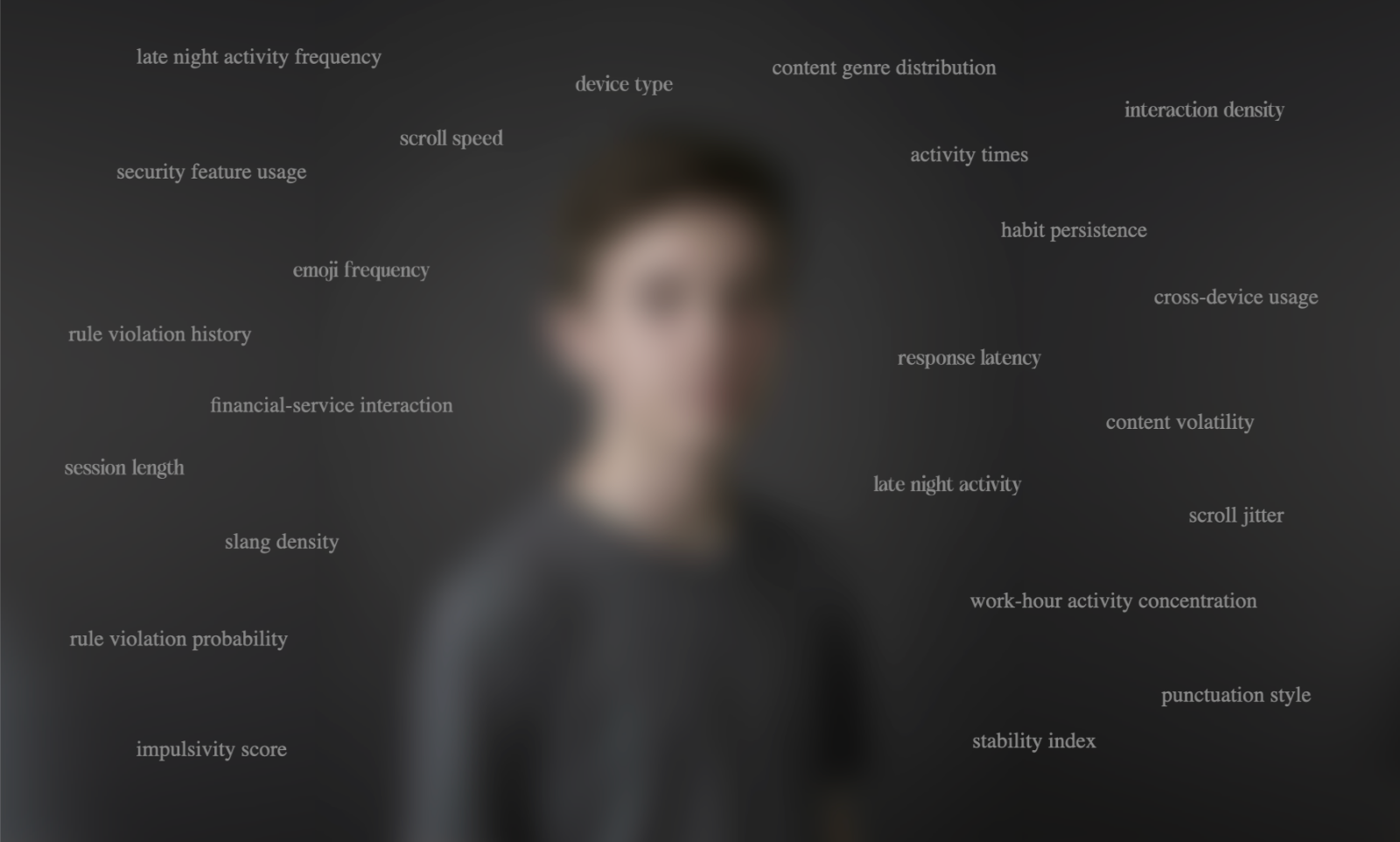

Aus solchen Setzungen werden Trainingsdaten. Aus Trainingsdaten werden Modelle. Aus Modellen werden Entscheidungen. So wird ein bestimmtes Altersbild Teil technischer Infrastruktur und wird über Proxy-Variablen rekonstruiert: Sprachstil, Emoji-Nutzung, Musikreferenzen, Interaktionsfrequenz, Tageszeiten, Gerätewahl.

Diese Marker sind kulturell geprägt. Sie zeigen, wie bestimmte Gruppen kommunizieren, welche Plattformen sie nutzen und welche Referenzen sie teilen. Wenn solche Muster als Altersbeweis gelten, wird ein kultureller Stil als individuelles Merkmal gelesen.

Die Idee, Alter aus Verhalten abzuleiten, ist älter als KI.

Age-Inference-Modelle erscheinen erst einmal wie ein Produkt aktueller KI-Entwicklungen. Tatsächlich reicht die Logik weiter zurück.

Bereits 2006 untersuchte der Informatiker und Machine-Learning-Forscher Jeffrey Schler gemeinsam mit Kolleg:innen, ob sich Alter aus Blogtexten ableiten lässt. Die Ergebnisse zeigten statistisch signifikante Muster.

2013 untersuchte der Computational-Social-Science-Forscher H. Andrew Schwartz Millionen Social-Media-Beiträge. Auch hier zeigte sich, dass Alter aus Sprachmustern als Wahrscheinlichkeit rekonstruiert werden kann.

Die Wurzeln liegen in der computerbasierten Sprachforschung und der quantitativen Verhaltensanalyse. KI erfindet dieses Prinzip nicht neu. Sie verstärkt es. Mehr Daten. Komplexere Modelle. Höhere Rechenleistung. Die Annahme bleibt dieselbe: Verhalten erzeugt Muster, die statistisch analysiert werden können.

Zwischen statistischer Beobachtung und operativer Infrastruktur liegt ein Bruch.

Dass sich Alter modellieren lässt, ist empirisch belegt. In der Forschung bleibt ein Modellwert eine Wahrscheinlichkeit mit Fehlermarge. Sobald er in Plattformarchitekturen einfließt, wird daraus Entscheidungsgrundlage. Zugang oder Sperre. Sichtbarkeit oder Unsichtbarkeit. Freigabe oder Einschränkung.

Hier beginnt die kulturelle Dimension.

Korrelation ist keine Identität.

Wahrscheinlichkeit ist kein Wesen.

Statistik ist kein Charakter.

Wenn Sprachmuster mit Altersgruppen korrelieren, definiert das kein Individuum. Modelle abstrahieren. Sie aggregieren. Sie vereinfachen. Und jede Vereinfachung legt fest, was als relevant gilt.

Was in der Forschung als Statistik begann, wird in digitalen Systemen zur Entscheidungsarchitektur.

Wenn Alter operationalisiert wird, wird es Teil von Machtarchitekturen.

Untersuchungen zur Altersschätzung in KI-Systemen zeigen deutliche Unterschiede in den Fehlerraten, abhängig von Datensatz und Gruppe. Wo Trainingsdaten nicht divers genug sind oder Alter nur über Proxy-Merkmale geschätzt wird, entstehen systematische Verzerrungen. Unsichtbar im Interface. Wirksam im Hintergrund.

Sind bestimmte Altersgruppen im Datensatz unterrepräsentiert, steigt nicht nur die Fehlerrate. Es entsteht eine strukturelle Schieflage. Modelle sind präziser für dominante Gruppen, andere bleiben statistisch unscharf. Diese Unschärfe bleibt im Interface unsichtbar, wirkt aber operativ. Sie beeinflusst Zugang, Sichtbarkeit und Risikoeinstufungen.

Spotify zeigt die weiche Variante. Ein spielerischer Spiegel, der Neugier als Jugend liest und Nostalgie als höheres Alter. Discord und ChatGPT zeigen die operative Version. Hier entscheidet die Zuschreibung über Handlungsspielräume.

Schutzmechanismen sind notwendig.

Und Plattformen tragen Verantwortung.

Alter ist eine soziale Kategorie mit Geschichte, die Macht, Zugang und Relevanz strukturiert. Wird sie in Code übersetzt, darf das nicht im Verborgenen geschehen. Automatisierte Entscheidungen müssen nachvollziehbar und anfechtbar sein. Sonst wird Infrastruktur zur Blackbox.

Die entscheidenden Fragen sind einfach:

Wie hoch ist die Fehlerrate?

Wer wird systematisch unscharf modelliert?

Wie werden Grenzfälle behandelt?

Und wofür wird Alter genutzt – Schutz oder Sortierung?

Der Übergang vom Geburtsdatum zur Wahrscheinlichkeit verändert unsere Vorstellung von Identität.

Hier liegt die eigentliche Verschiebung.

Alter war bislang ein administrativer Marker. Eine feste Größe. Jetzt wird es zur kontextabhängigen Kategorie. Nicht mehr nur eingetragen, sondern modelliert. Das eröffnet Spielräume. Lebensphasen verlieren ihre starre Reihenfolge. Zugänge können sich stärker am Verhalten orientieren als am eingetragenen Alter.

Doch Einordnung verschwindet nicht. Sie verlagert sich. Statt klarer Altersgrenzen wirken statistische Muster. Statt fester Schwellen greifen Wahrscheinlichkeiten. Es entstehen neue, weniger sichtbare Schubladen.

Das ist kein radikaler Umbruch, sondern die technologische Zuspitzung bestehender Logiken. Kredit-Scoring und Empfehlungsalgorithmen arbeiten seit Jahren mit impliziten Annahmen über Lebenslagen. Alter war nie neutral. Jetzt wird es systematisch berechnet.

Die Frage nach dem Alter im Code ist eine Frage nach unserem Menschenbild.

Welche Rolle soll Alter in digitalen Infrastrukturen spielen?

Zugangsschwelle. Schutzmechanismus. Oder unsichtbare Sortierlogik.

Entscheidend ist nicht, dass solche Modelle existieren. Entscheidend ist, wie sie eingebettet sind. Alterszuschreibungen dürfen nicht zu stillen Entscheidungsgrundlagen werden, deren Annahmen im System verschwinden. Wenn Alter berechnet wird, muss nachvollziehbar sein, zu welchem Zweck, mit welchen Daten, mit welchen Fehlermargen und mit welchen Grenzen.

Sobald Wahrscheinlichkeit zur Infrastruktur wird, verschieben sich Handlungsspielräume. Alter im Code entscheidet, wer als reif, riskant oder relevant gilt.

Ob Alter schützt oder selektiert, wird nicht im Interface entschieden, sondern in Modellarchitekturen, Trainingsdatensätzen und Produktentscheidungen.

Modellierung ist Auswahl. Auswahl ist Reduktion. Reduktion basiert auf Daten. Wer Datensätze definiert und Korrelationen akzeptiert, prägt das Altersbild im System. Technische Architektur ist immer auch kulturelle Setzung.

Nicht die Berechenbarkeit ist die Frage.

Sondern ihre Bedeutung.

Wo Berechnung beginnt, beginnt Verantwortung.

Wenn Alter zur Variable wird, reicht technische Präzision nicht.

Entscheidend sind die Bedingungen, unter denen diese Variable operiert.

Transparenz.

Welche Daten liegen zugrunde? Welche Annahmen prägen das Modell? Welche Fehlermargen werden akzeptiert? Ein berechnetes Alter darf keine Blackbox sein.

Zweckbindung.

Dient die Zuschreibung dem Schutz, oder wird sie zum stillen Sortierkriterium für Sichtbarkeit, Priorisierung und Risikoeinstufung?

Anfechtbarkeit.

Kann eine Wahrscheinlichkeit korrigiert werden, oder verfestigt sie sich zur Identität?

Fehlen diese Bedingungen, wird aus Berechnung schnell Selektion.

Und genau dort entscheidet sich, welche Form von „Normalität“ wir digital etablieren.